HBM4 là gì? Tìm hiểu công nghệ bộ nhớ băng thông cao thế hệ mới nhất

HBM4 đánh dấu cột mốc quan trọng khi mang lại băng thông lớn, hiệu suất ổn định và mức tiêu thụ điện năng tối ưu, phù hợp cho môi trường tính toán chuyên sâu. Cùng MemoryZone khám phá tiềm năng thực sự của chuẩn bộ nhớ đang dẫn đầu xu hướng AI hiện nay.

1. HBM4 là gì? Tìm hiểu bộ nhớ băng thông cao thế hệ mới

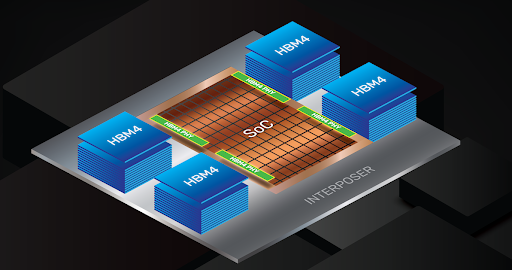

HBM4 (High Bandwidth Memory 4) là chuẩn bộ nhớ băng thông cao thế hệ kế tiếp, được thiết kế cho GPU AI, accelerator và siêu máy tính với bus I/O 2.048-bit gấp đôi HBM3E. Công nghệ này kế thừa kiến trúc stack dọc 3D, sử dụng TSV (Through-Silicon Via) để tăng mật độ và băng thông, nhắm tới nhu cầu AI training/inference quy mô exascale.

HBM4 - Phá vỡ giới hạn băng thông bộ nhớ truyền thống

SK hynix dẫn đầu khi hoàn tất phát triển HBM4 đầu tiên thế giới tháng 9/2025, theo sau là Samsung và Micron với mẫu thử cung cấp cho NVIDIA Rubin. HBM4 không chỉ tăng tốc độ mà còn cải thiện hiệu suất năng lượng 40-50% so với thế hệ trước, giải quyết nút thắt bộ nhớ trong data center AI.

2. Thông số nổi bật của HBM4

Các thông số ước tính/đang được công bố của HBM4 (tùy nhà sản xuất và cấu hình) gồm:

-

Bus I/O: 2.048‑bit, gấp đôi 1.024‑bit của HBM3/HBM3E, giúp tăng băng thông ngay cả khi tốc độ mỗi chân không tăng nhiều.

-

Tốc độ chân (pin speed): mục tiêu từ khoảng 8-10 Gb/s mỗi chân, kết hợp bus rộng cho băng thông khoảng 2-2,5 TB/s trên mỗi stack, gần gấp đôi HBM3E.

-

Dung lượng: dùng các die 24 GB và 32 GB, hỗ trợ stack 4‑high tới 16‑high, cho phép dung lượng mỗi stack lên đến hàng trăm GB trên một package HBM.

Nhờ tăng băng thông chủ yếu bằng cách mở rộng bus thay vì chỉ tăng xung, HBM4 có tiềm năng cải thiện đáng kể hiệu suất trên mỗi watt so với HBM3E trong các tác vụ AI training và inference liên tục.

Kiến trúc mới cũng cho phép tối ưu đường đi tín hiệu và giảm tỷ lệ lỗi ở mật độ kênh rất lớn, điều đặc biệt quan trọng khi GPU cần truy cập bộ nhớ với độ trễ thấp và thông lượng cực cao.

HBM4 tiết kiệm 40-50% điện năng so với thế hệ trước

Mời bạn khám phá thêm các mẫu RAM giá tốt, độ tương thích cao, tăng tốc độ xử lý dữ liệu, ưu đãi lên đến 30%:

3. Bảng so sánh HBM3E vs HBM4

Dưới đây là bảng tóm tắt một số điểm khác biệt kỹ thuật chính giữa HBM3E và HBM4 (con số có thể thay đổi nhẹ tùy nhà sản xuất, cấu hình và thế hệ sản phẩm cụ thể):

|

Thuộc tính |

HBM3E |

HBM4 |

|

Độ rộng bus I/O |

1.024‑bit |

2.048‑bit (gấp đôi HBM3E) |

|

Tốc độ mỗi chân (pin speed) |

~8-9,6 Gb/s; một số IP tới ~10,4 Gb/s |

~8-10 Gb/s (mục tiêu, tùy vendor) |

|

Băng thông mỗi stack |

~1,0-1,23 TB/s |

~2,0 TB/s hoặc hơn (gần gấp đôi) |

|

Số lớp (stack height) |

Thường 8‑high, 12‑high; tới 16‑high |

4‑high, 8‑high, 12‑high, 16‑high |

|

Dung lượng mỗi stack |

~16-36 GB, lên đến >48 GB tùy thế hệ |

Dự kiến cao hơn nhờ die 24/32 GB |

|

Ứng dụng phổ biến |

GPU AI H200, GH200, accelerator AI hiện tại |

GPU AI thế hệ mới như Rubin, nền tảng AI exascale |

4. Lộ trình sản xuất HBM4 theo nhà sản xuất

Thị trường HBM bước vào giai đoạn cạnh tranh mới khi các nhà sản xuất đồng loạt công bố kế hoạch đưa HBM4 vào sản xuất hàng loạt.

-

SK hynix: Hoàn tất phát triển tháng 9/2025, đặt thiết bị sản xuất từ tháng 11/2025, mass production dự kiến nửa sau 2025 hoặc đầu 2026 để kịp NVIDIA Rubin.

-

Micron: Bắt đầu mass production nửa đầu 2026 (fiscal H1 FY2026), đã giao mẫu lên đến 11 GT/s và ký hợp đồng khách hàng.

-

Samsung: Giao mẫu sớm Q3/2025, mass production Q4/2025 hoặc Q2-Q3/2026 do thử thách yield 1c-nm, giới thiệu HBM4 nhanh hơn tại ISSCC tháng 2/2026

Samsung & Micron: Samples sẵn sàng cho GPU mới

5. Ứng dụng thực tế của HBM4

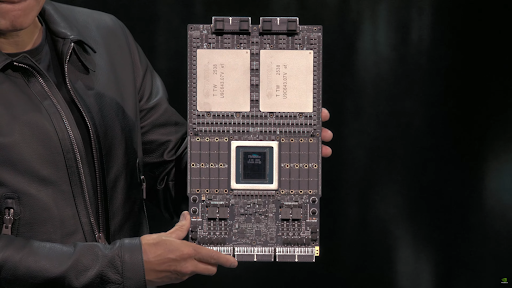

HBM4 sẽ xuất hiện đầu tiên trên GPU NVIDIA Rubin (Vera Rubin NVL144) ra mắt nửa sau 2026, với NVIDIA đã nhận mẫu từ tất cả nhà cung cấp lớn và chip đang vào production.

Tại sự kiện GTC 2025, Nvidia giới thiệu Vera Rubin Superchip - thiết kế kết hợp CPU Vera và hai GPU Rubin trong một nền tảng, tăng hiệu suất xử lý cho data center thế hệ mới. Việc Rubin vào sản xuất sớm cho thấy NVIDIA đúng lộ trình ra mắt siêu chip này năm 2026.

NVIDIA Rubin: GPU AI đầu tiên dùng HBM4

6. Một số câu hỏi thường gặp về HBM4

6.1 Khi nào HBM4 sản xuất hàng loạt?

Nửa đầu 2026: SK hynix/Micron dẫn đầu, Samsung Q2-Q3/2026.

6.2 HBM4 có dùng cho PC cá nhân/gaming không?

Chủ yếu cho GPU AI data center (NVIDIA Rubin). PC gaming vẫn dùng GDDR7, workstation cao cấp có thể tích hợp sau 2027.

6.3 HBM4 cải thiện hiệu suất AI thế nào?

HBM4 cải thiện hiệu suất bằng cách tăng băng thông gấp đôi → training/inference nhanh hơn 1.5-2x, giảm độ trễ, hỗ trợ mô hình AI lớn hơn (trillion parameters).

7. Kết luận

Với băng thông mạnh mẽ và hiệu quả tối ưu, HBM4 được kỳ vọng trở thành chuẩn bộ nhớ chủ lực cho AI và GPU thế hệ mới. Theo dõi MemoryZone để cập nhật ngay thông tin mới nhất về các giải pháp bộ nhớ hiện đại, hỗ trợ người dùng bắt kịp xu hướng công nghệ.