Maia 200: Chip AI inference Microsoft ra mắt 2026 có gì đặc biệt?

Ngày 26 tháng 1 năm 2026, Microsoft chính thức giới thiệu Maia 200, thế hệ chip AI accelerator mới nhất được xây dựng đặc biệt cho các tác vụ suy luận (inference). Đây là bước đi chiến lược trong lộ trình tự chủ hạ tầng “heterogeneous” (không đồng nhất) của Microsoft, giảm phụ thuộc vào nguồn cung bên ngoài và tối ưu chi phí vận hành các mô hình ngôn ngữ lớn (LLM).

Khác với các dòng GPU đa năng, Maia 200 được định vị là một “inference powerhouse” với mục tiêu chính: cải thiện kinh tế trong việc tạo token (economics of token generation). Chip đã được đưa vào hoạt động ngay tại thời điểm ra mắt ở trung tâm dữ liệu Azure US Central (gần Des Moines, Iowa).

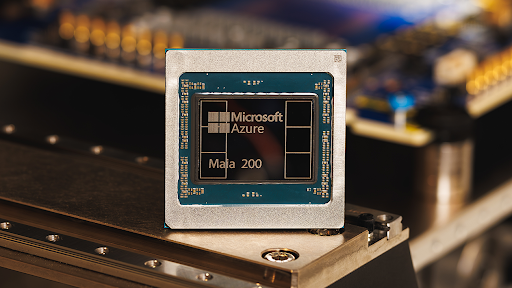

Chip Maia 200 trên tiến trình 3nm TSMC với hơn 140 tỷ transistors

Thông số kỹ thuật và công nghệ nổi bật của Maia 200

Dưới đây là các thông số chi tiết của Maia 200, được tối ưu đặc biệt cho tác vụ suy luận AI quy mô lớn (inference at scale), dựa trên công bố chính thức từ Microsoft:

Quy trình sản xuất và cấu trúc chip:

-

Được chế tạo trên tiến trình 3nm tiên tiến của TSMC - một trong những node sản xuất nhỏ nhất hiện nay, giúp tối ưu hóa hiệu suất trên mỗi watt điện (performance per watt) cho workload inference dài hạn.

-

Mỗi chip Microsoft Maia 200 chứa hơn 140 tỷ bóng bán dẫn (transistors), tạo nên mật độ transistor cực cao để xử lý các mô hình AI lớn mà vẫn giữ hiệu quả năng lượng.

-

Sử dụng thiết kế SoC (System-on-Chip) hoàn chỉnh với mức tiêu thụ điện năng (TDP) giới hạn ở 750W, bao gồm toàn bộ compute cores, memory controllers và I/O trong một die duy nhất, giúp giảm độ trễ và tăng độ tin cậy khi triển khai datacenter.

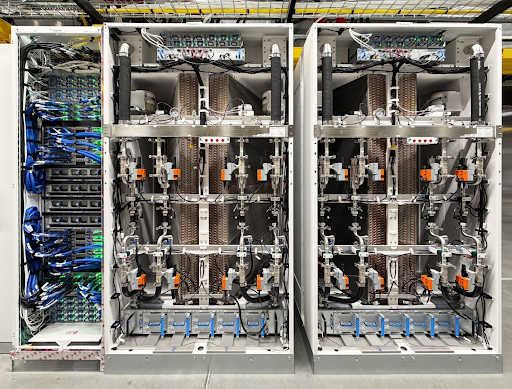

Tray chứa 4 chip Maia 200 kết nối trực tiếp không qua switch

Hiệu năng tính toán (Compute Performance):

-

Tích hợp các nhân Tensor (Tensor Cores) hỗ trợ natively định dạng FP4 và FP8, đón đầu xu hướng suy luận độ chính xác thấp (low-precision inference). Hiệu năng FP4 đạt trên 10 petaFLOPS mỗi chip. Hiệu năng FP8 đạt trên 5 petaFLOPS mỗi chip.

-

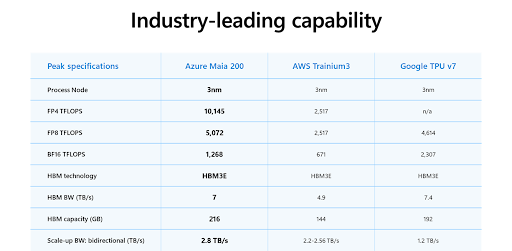

So sánh hiệu năng: Theo công bố chính thức, Microsoft khẳng định Maia 200 có hiệu suất FP4 cao gấp 3 lần so với Amazon Trainium thế hệ 3 và hiệu suất FP8 vượt trội hơn so với Google TPU thế hệ 7, khẳng định vị thế dẫn đầu trong mảng phần cứng suy luận AI (“most performant, first-party silicon from any hyperscaler”).

Bảng so sánh hiệu năng Maia 200 với Amazon Trainium và Google TPU

Hệ thống bộ nhớ (Memory Subsystem):

-

Trang bị 216GB bộ nhớ HBM3e với băng thông lên tới 7 TB/s, kết hợp cùng 272MB SRAM on-chip tốc độ cao.

-

Thiết kế tập trung vào việc giải quyết nút thắt cổ chai về dữ liệu (data feeding bottleneck) với các công cụ chuyên biệt như DMA engine và mạng kết nối trên chip (NoC) băng thông cao, giúp tối đa hóa thông lượng token (token throughput).

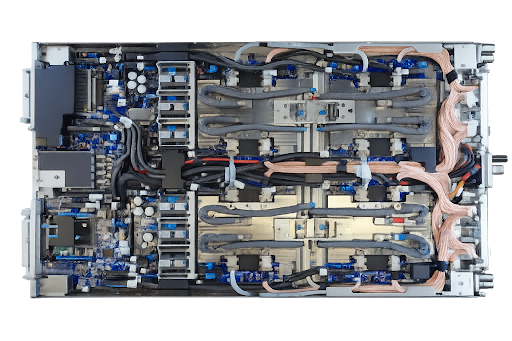

Hệ thống mạng và kết nối (Networking & Interconnect):

-

Sử dụng kiến trúc mạng scale-up hai tầng (two-tier scale-up network) xây dựng trên Ethernet tiêu chuẩn, với custom transport layer và NIC tích hợp chặt chẽ, không dựa vào proprietary fabrics.

-

Mỗi accelerator cung cấp 2.8 TB/s băng thông scale-up hai chiều (bidirectional), dạng dedicated.

-

Hỗ trợ collective operations hiệu năng cao và dự đoán trên các cụm lên đến 6.144 accelerators. (Nguồn: Microsoft)

-

Trong mỗi tray, 4 Maia accelerators được kết nối trực tiếp bằng các liên kết non-switched, giúp giữ giao tiếp băng thông cao ở phạm vi cục bộ để tối ưu hiệu quả inference.

Cấu trúc tray Maia 200 với liên kết non-switched

Hỗ trợ phần mềm (Software Stack):

-

Maia SDK (Preview): Bộ công cụ phát triển phần mềm bao gồm trình biên dịch Triton Compiler, hỗ trợ tích hợp PyTorch, thư viện kernel tối ưu hóa.

-

Low-level Programming: Cung cấp quyền truy cập vào ngôn ngữ lập trình cấp thấp (NPL) của Maia cho các nhu cầu kiểm soát sâu (fine-grained control).

-

Công cụ tối ưu: Tích hợp trình mô phỏng (Maia Simulator) và công cụ tính toán chi phí (Cost Calculator) giúp tối ưu hóa hiệu quả ngay từ giai đoạn đầu của vòng đời code.

Triển khai và ứng dụng thực tế của Maia 200

Vị trí triển khai (Deployment Regions): Ngay tại thời điểm ra mắt, Microsoft xác nhận Maia 200 đã được triển khai và đi vào hoạt động tại trung tâm dữ liệu Azure vùng US Central (gần Des Moines, Iowa). Kế hoạch mở rộng tiếp theo đã được ấn định cho vùng US West 3 (gần Phoenix, Arizona) cùng các vùng khác trong tương lai.

Các workload trọng điểm:

-

Chip được sử dụng để vận hành nhiều mô hình AI quan trọng, bao gồm GPT-5.2 của OpenAI, đồng thời mang lại lợi thế về hiệu năng cho các dịch vụ Microsoft Foundry và Microsoft 365 Copilot.

-

Đặc biệt, đội ngũ Microsoft Superintelligence là những người tiên phong sử dụng Maia 200 cho các tác vụ chuyên sâu như tạo dữ liệu tổng hợp (synthetic data generation) và học tăng cường (reinforcement learning) nhằm huấn luyện các mô hình thế hệ tiếp theo.

Hiệu quả kinh tế vượt trội: Microsoft tuyên bố Maia 200 là hệ thống suy luận hiệu quả nhất mà họ từng triển khai. Cụ thể, chip mang lại hiệu suất trên mỗi đô la (performance per dollar) tốt hơn 30% so với các phần cứng thế hệ mới nhất đang có trong hạ tầng (fleet) hiện tại của hãng.

Sự ra mắt của Maia 200 vào đầu năm 2026 mở rộng khả năng “first-party silicon” của Microsoft cho AI inference. Với sự kết hợp giữa tiến trình 3nm, bộ nhớ HBM3e băng thông lớn và mạng scale-up Ethernet, chip mang đến giải pháp tối ưu chi phí và hiệu năng cho các bài toán inference ngày càng phức tạp.

Nếu bạn đang quan tâm đến việc xây dựng hệ thống phần cứng hỗ trợ AI (PC/Workstation) với các linh kiện lưu trữ và bộ nhớ hiệu năng cao, đừng quên tham khảo các sản phẩm chính hãng tại MemoryZone để có sự lựa chọn phù hợp nhất cho nhu cầu của mình.